编者按:本文是微软副董事长兼总裁布拉德·史密斯(Brad Smith)为微软公司的报告《Governing AI: Blueprint for the Future》(暂译《治理人工智能:未来蓝图》)撰写的前言。

布拉德·史密斯提供了独到的见解,引领着我们深入思考人工智能对工作和生活的影响:每个人既能从人工智能技术的进步中受益,又因此而面对着前所未有的挑战。在前言中,他分享了对于人工智能治理策略和人机关系的见解和思考,同时还介绍了微软内部在实施人工智能治理方面的做法。

“不要问计算机能做什么,而要问它们应该做什么。”

2019年,在一本我参与合著的关于人工智能伦理的书中,上面这句话是其中一个章节的标题。当时,我们写道:“这可能是我们这一代人面临的最核心的问题之一。”四年过去了,这个问题不仅引起了全世界的关注,而且成为许多人茶余饭后的话题。

那些曾经使用,或是听说过 Open AI 的 GPT-4 基础模型的人,多半会为其强大的能力感到震惊。有人为此激动不已,也有人因此对未来充满担忧。但有一点毋庸置疑,早在四年前,我们就已经意识到,我们正在创造人类历史上第一代能像人类一样做决策的机器。

大家提出的共同问题是,如何利用这项新技术解决我们的问题?我们又该如何防范和应对由新技术可能引发的新问题?我们应该如何掌控如此强大的技术?

要解决这些问题,不仅需要广泛而深入的讨论,还需要果断而有效的行动。这篇报告将从企业的视角提供一些思路和建议。

这些建议基于多年来我们在实际工作中积累的经验。早在2016年,微软首席执行官萨提亚·纳德拉(Satya Nadella)就曾指出:“或许我们最需要进行的讨论并非是关于善恶,而是应该向创造这项技术的人或组织传递怎样的价值观。”

自那时起,我们就通过定义、发布和实施人工智能的伦理准则来指导我们的工作,并通过建立不断优化的工程和治理体系,将伦理准则付诸实践。如今,微软设立了近350人的团队,专注于推动负责任的人工智能,确保我们能够最大程度地构建安全、可靠和透明的人工智能系统,以造福全社会。

探索改善人类生活的新途径

已取得的进展让我们更加有信心,去持续探索利用人工智能改善人类生活的新途径。我们见证了利用人工智能帮助人们挽救视力,推动癌症新疗法的研究,揭秘蛋白质,通过气象预测避免自然灾害等。

人们的日常工作与生活也会从人工智能技术中受益。GPT-4 这样的基础模型可以成为人们的智能副驾,将搜索转变为更强大的研究工具,并提高人们在工作中的生产力。对于那些不知如何帮助孩子学习代数的父母来说,人工智能也将成为一位良师益友。

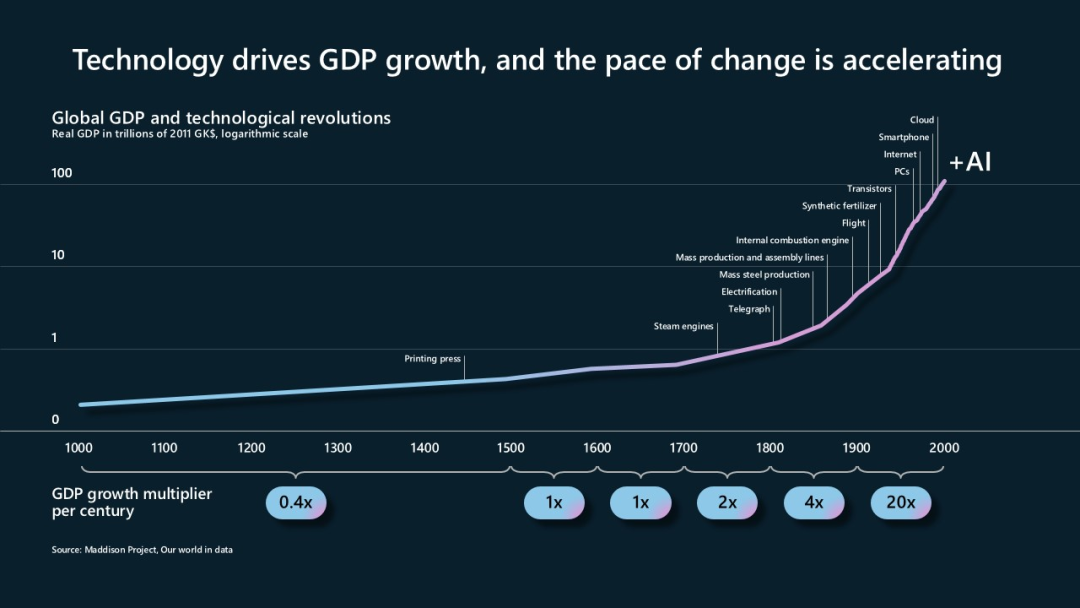

人工智能是一项革命性的创新。自15世纪铅活字版印刷术(铅活字印刷机)发明以来,科技的发展从未停歇。蒸汽机、电力、汽车、飞机、计算机和互联网等发明为现代文明奠定了基石。就像移动活版印刷术一样,人工智能也为促进人类的学习和思考提供了全新的工具。

技术推动 GDP 增长的步伐在不断加快

未来的护栏

当然,仅仅聚焦于利用人工智能改善人们的工作生活还是远远不够的。

如今,经过不断的成长和沉淀,我们比之前更加成熟、更加明智,我们需要将这些智慧付诸实践,并且及时厘清可能出现的问题。随着技术的不断进步,确保人工智能的可控性与追求其发展同样重要。作为一家公司,我们一直致力于以安全和负责任的方式开发和应用人工智能。然而,我们也认识到,为人工智能设立护栏、确保人工智能安全所需的监管措施是所有人共同的责任,而不能仅仅依赖科技公司单方面的努力。

2018年,微软制定了六项人工智能伦理准则。其中,“责任”是其他所有准则的基石,这是一条根本性的原则,它将确保机器始终受到人类的有效监督,而设计和操作机器的人也必须对其他人负责。简而言之,我们必须始终确保人工智能处于人类的掌控之中,这应该成为政府和科技公司的首要职责。

在法治社会中,没有人或公司能够凌驾于法律之上,同样也没有产品或技术可以凌驾于法律之上。因此,设计和操作人工智能系统的个人或者公司,只有在其决策和行动受到法律约束时,才能真正承担起责任。

政府应该如何有效确保人工智能受到法律的约束?这是很多相关政策和监管的讨论核心。简而言之,新的法律、法规和政策应该采取何种形式来约束人工智能?

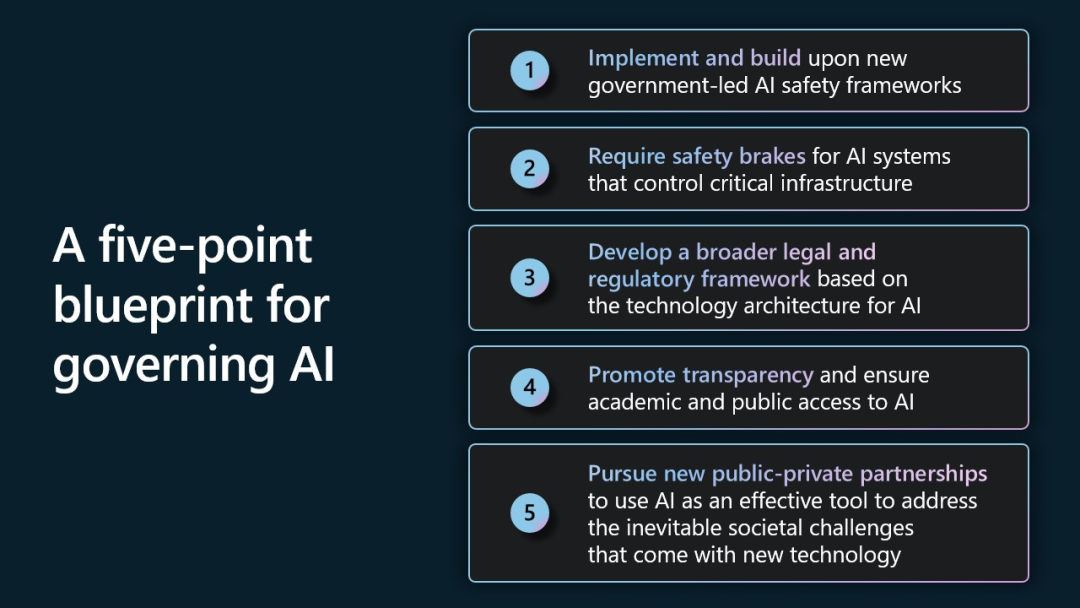

人工智能公共治理的五大关键策略

下面我们将从公共政策、法律和监管等方面,探讨当前人工智能的关键问题。我们讲述的这五大关键策略,每一条都仍需更广泛的讨论和深入的研究,在此之前,希望我们的经验能对未来的工作做出一些建设性的贡献。

人工智能公共治理的五大关键策略

第一,构建并实施以政府为主导的人工智能安全框架。通向成功的道路往往建立在他人的成功经验之上,对于需要快速推进的项目来说更是如此。在这种情况下,我们可以借鉴公共部门和商业机构已有的人工智能风险管理条例,结合本地化需求有的放矢地完善人工智能安全框架。

第二,必须对控制关键基础设施的人工智能系统设置有效的安全制动机制。越来越多的人开始担忧,随着人工智能的日益强大,我们是否有能力有效地控制它?很多人对于让人工智能控制关键基础设施(如电网、水系统和城市交通等)感到忧虑。

针对上述担忧,我们已经提议了新的安全规范,为控制关键基础设施的人工智能系统创建了安全的制动机制。这类防范故障的安全系统将成为人工智能综合安全治理的一部分,它将受到有效的人为监督,并将灵活性和稳定性放在首位。本质上,该系统与其他技术领域中的刹车系统非常类似,就像电梯、校车和高铁列车的制动系统一样,旨在保障设备日常及紧急情况下的运行安全。

在上述制动机制中,政府将负责界定哪些控制关键基础设施的人工智能系统属于高风险范畴,并要求这些系统在设计之初,就将安全制动机制作为系统综合安全治理的一部分嵌入其中。新的法律条文也将明确要求这些系统的运营者在设计之初就为高风险的人工智能系统设置好安全制动机制。政府会要求运营商定期测试高风险系统,以最大程度地保障系统安全措施的有效性。控制关键基础设施运行的人工智能系统,只能在获得许可的人工智能数据中心里部署和运行,安全制动机制会为这些数据中心提供第二层保护,从而进一步确保人工智能的人为可控性。

第三,基于人工智能技术架构制定广泛适用的法律和监管框架。我们认为,需要为人工智能建立一套针对其技术架构特点的法律和监管体系。简而言之,法律需要根据各方在管理人工智能的过程中的不同角色,来分配相应的监管职责。

为了实现分层监管,五大策略涵盖了构建和使用生成式人工智能模型所需的一些关键要素。同时,针对不同的技术栈,我们建议分三个层次来制定相应的法律条款,即针对处于应用层、模型层和基础设施层的不同组织机构匹配特定的监管职责。

首先,我们将现有的法律保护措施作用于人工智能的应用层。这是对人们的安全和权益影响最大的一层,人工智能产生的影响在不同的应用场景中会存在显著差异。在许多领域中,我们都不需要新的法律法规,而只需应用和执行现有的条款,帮助法院和组织机构发展出适应于新型人工智能场景所需的专业知识。

接下来,需要针对高度智能的人工智能基础模型层制定新的法律和法规,并且最好由一个新设立的政府机构负责实施。这些针对性的法律法规将影响技术栈的其中两个层次。第一层,需要针对这些模型本身制定新的监管和许可规定。第二层,需要对开发和部署这些人工智能模型的基础设施运营商制定义务条例。五大策略分别为每个层次提供了建议的目标和方法。

我们在一定程度上借鉴了近几十年来,银行业所采取的一些原则,它们曾被用于防止洗钱、犯罪,或是防止金融服务被恐怖分子利用。银行业所谓的“了解你的客户” (Know Your Customer,KYC)原则,即要求金融机构核实客户的身份、建立风险档案,并监测交易以辅助发现可疑活动。我们将这一原则应用于人工智能领域,并采用一种被称为 KY3C(了解云平台、了解客户和了解内容)的方法,来确立人工智能环境中的一些义务,这显然是一件非常有意义的事情。

应用于人工智能领域的 KY3C 方法

作为例证,首先,特定的、强大的人工智能模型开发者需要“了解云”,即了解他们的模型在哪个云平台上进行开发和部署。

其次,对于涉及敏感用途的情况,那些直接面对客户的公司(无论是模型开发者、应用提供者还是托管模型的云服务提供商)都应该“了解客户”。

最后,公众有知情权,即通过标签或其他标识方式,告知人们某个视频或音频文件是由人工智能模型生成的,而非人类创作。这种标注义务还可保护公众免受“被篡改的内容”和“深度伪造的内容”的影响。这些都需要制定新的法律条款,并且还有许多重要的问题和细节有待解决。细致缜密的措施将有助于遏制利用新技术欺骗欺诈公众的行为,未来社会的和谐发展都将得益于此。

第四,提高人工智能的透明度,确保学术界和非营利组织能够获得人工智能资源。我们认为提高透明度并扩大人工智能访问的授权范围是很关键的公共目标。虽然透明度与安全需求之间存在一些相悖之处,但我们仍有很多机会能以负责任的方式使人工智能系统更加透明——这就是微软承诺每年发布一份人工智能透明度报告的原因。我们还会采取多项举措进一步扩大人工智能服务的透明度。

我们认为,扩大学术机构和非营利组织获得人工智能资源的机会至关重要。应拓宽学术研究人员获取人工智能资源的途径,否则科学技术研究(包括与人工智能本身有关的研究)将面临真正的风险。我们呼吁采取新的措施,包括微软已经在执行的多项举措,以期优先应对上述挑战。

第五,积极推动公共机构和商业组织的广泛合作,将人工智能作为一种有效的工具,去应对新技术带来的,不可避免的社会挑战。近年来,我们总结出一项经验:利用技术的力量将公共部门和商业机构联合起来,便会取得令人瞩目的成就。我们可以借鉴这一经验,抵御人工智能对社会的消极影响。

我们要保持清醒的乐观主义精神,人工智能是一种非凡的工具,但它也像其他技术一样,可能会在一些目的不良之人的手中变成可怕的武器。幸而,我们可以从过往经验中获得一些信心——我们发现,当公共部门和商业机构共同努力,并与志同道合的盟友团结一致时,便能将我们所开发的技术当做“盾牌”来使用,它将会比地球上任何一柄“利剑”都更为强大。

目前工作的重点是,如何利用人工智能来保护人民的基本权利,拓宽获得人工智能资源的机会,以提高包容性,并利用人工智能的力量推进地球的可持续发展。或许,最重要的是,新一轮人工智能技术为我们提供了一个大胆思考、勇敢行动的机会。在任一领域,成功的关键都在于制定具体的倡议,并且联合政府、受人尊敬的企业和充满活力的非政府组织共同推动这些倡议的落地。对此,我们在报告中提出了一些初步的想法,并期待在未来的几个月或几年中能够取得更多的进展。

微软内部的人工智能治理

最终,每个创建或使用人工智能系统的组织都需要开发和实施自己的治理体系。报告的第二部分描述了微软的人工智能治理体系,包括我们的起点、现状及未来的发展方向。

正如第二部分内容所指出的,为新技术建立一个新的治理体系本身就是一段漫长的旅程。十年前,我们对这一领域的探索几乎为零。如今,微软有近350名专业人员致力于推动该领域的发展,我们还计划进一步扩大该团队的规模和投入。

过去六年,我们在微软内部建立起了更为全面的人工智能治理框架和体系。我们并非完全从零开始,而是从隐私保护和数字安全等优秀实践案例中汲取经验,它们和人工智能治理一样,都是企业风险管理(Enterprise Risk Management)体系的一部分,而后者已经成为世界上许多公司和组织的重要管理手段之一。

在人工智能领域,我们首先制定了伦理准则,然后将其转化为更具体的企业政策。目前我们已经在执行第二版的企业相关标准,该标准充分体现了上述伦理准则,并为我们的工程团队制定了更为精细的实践方法。我们通过培训、使用工具和测试系统来实施这一标准,并不断快速地完善它们。此外,我们还建立了监控、审计与合规措施等额外的治理流程。

和我们在生活中一样,经验永远是最好的老师。在人工智能治理方面,我们从审查敏感的人工智能应用案例中获得重要的经验。2019年,我们开启了敏感用途审查计划,对最敏感和最新颖的人工智能应用案例进行严格的专业审查。截至目前,我们已经完成了大约600个敏感用途案例的审查工作。随着人工智能技术的高速发展,这一审查计划的进程也不断加快——在过去的11个月当中,我们对近150个敏感用途案例进行了审查。

这一切都基于我们过去所做的工作,我们将继续通过企业文化推动负责任的人工智能发展。这意味着我们将招聘更多的新型多元化人才,来推动我们负责任的人工智能生态系统的发展。微软还会持续投资已有人才,培养他们的相关技能,使他们能够广泛思考人工智能系统对个人和社会的潜在影响。这也意味着,与过去相比,技术前沿更需要以多学科并举的方式来进行探索,即将优秀的工程师与才华横溢的文科专业人才结合起来。

报告提供的所有内容,都秉持负责任的精神,希望可以共同开创人工智能的未来之路。我们需要共同探索、相互学习,无论我们认为今天有多美好,都不能因此停滞不前。

随着技术变革的加速,负责任的人工智能治理工作也必须齐步而行。通过正确的承诺和投资,我们相信这是完全可行的。

文章来源:微软亚洲研究院微信公众号